AidGen SDK 开发者文档

简介

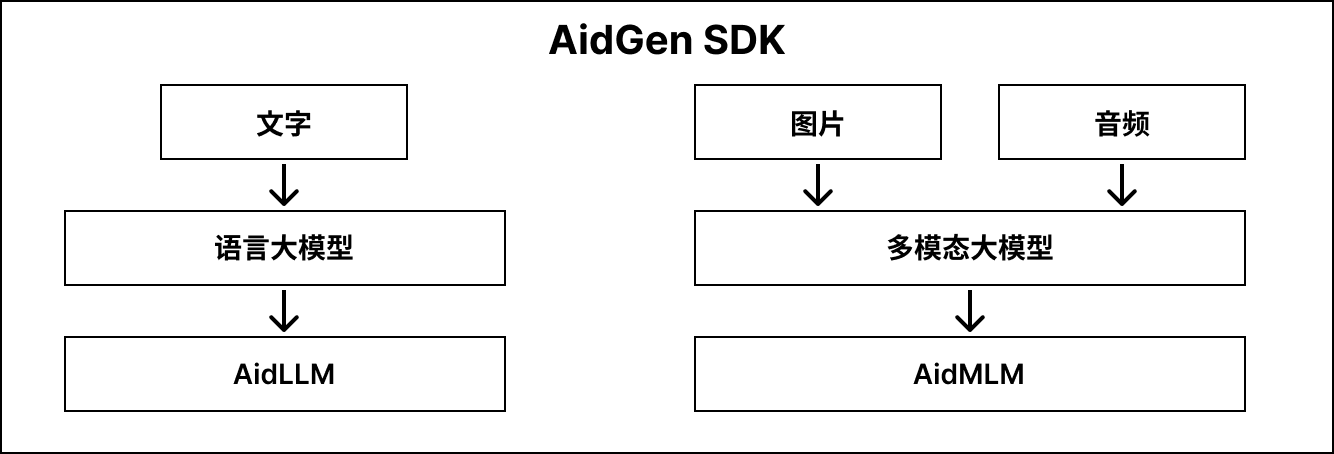

AidGen 是基于 AidLite 构建的专门针对生成式 Transformer 模型的推理框架,旨在充分调用硬件的各计算单元(CPU、GPU、NPU)实现大模型在端侧的推理加速。

AidGen 是SDK级别的开发套件,提供原子级别的大模型推理接口,适用于开发者将大模型推理集成到自己的应用中。

AidGen 支持多种类型的生成式 AI 模型:

- 语言类大模型 -> AidLLM 推理

- 多模态大模型 -> AidMLM 推理

其结构如下图所示:

💡注意

Model Farm 支持的大模型均通过 AidGen 实现在高通芯片NPU上的推理加速。

支持情况

模型种类支持情况

| AidLLM | AidMLM | |

|---|---|---|

| 文字 | ✅ | / |

| 图片 | / | ✅ |

| 音频 | / | 🚧 |

✅:已支持 🚧:计划支持

操作系统支持情况

| Linux | AidLux | Android | |

|---|---|---|---|

| C++ | ✅ | ✅ | / |

| Python | 🚧 | 🚧 | / |

| Java | / | / | 🚧 |

✅:已支持 🚧:计划支持

大语言模型 AidLLM SDK

安装

bash

sudo aid-pkg update

sudo aid-pkg -i aidgen-sdk模型文件获取

- 通过 Model Farm 大模型分区可以直接下载对应的模型文件及默认配置文件

- 通过命令直接获取并下载模型

bash

# 查看已支持的模型

aidllm remote-list api

# 下载模型

aidllm pull api [Url]

# 查看已下载模型

aidllm list api

# 删除已下载模型

sudo aidllm rm api [Name]示例应用

模型性能查看方式

💡注意

请确保示例应用能够完整执行成功

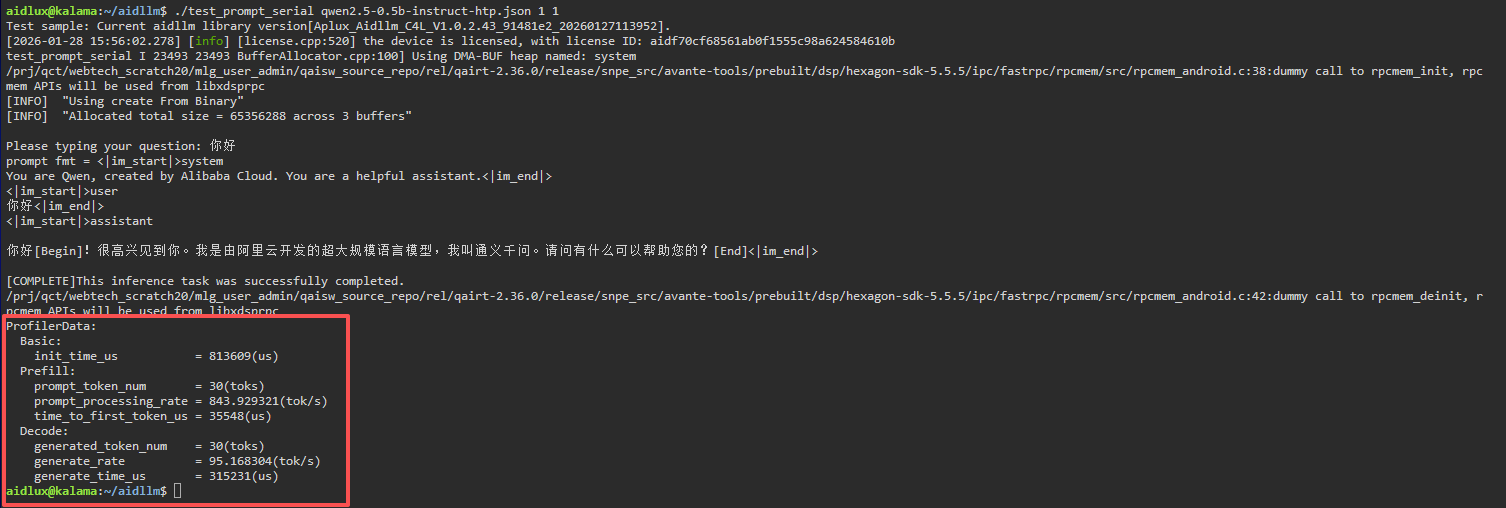

以示例在高通 QCS8550 上部署 Qwen2.5-0.5B-Instruct 为例子

bash

# 安装依赖

sudo apt update

sudo apt install libfmt-dev

# 编译

mkdir build && cd build

cmake .. && make

mv test_prompt_serial /home/aidlux/aidllm/

# 编译成功后运行

# 第一个参数 1 表示开启 profiler 统计

# 第二个参数 1 表示 推理循环次数

cd /home/aidlux/aidllm/

./test_prompt_serial qwen2.5-0.5b-instruct-htp.json 1 1- 在终端输入对话内容后会看到如下日志信息:

多模态视觉模型 AidMLM SDK

模型种类支持情况

| 模型 | 支持情况 |

|---|---|

| Qwen2.5-VL-3B-Instruct | ✅ |

| Qwen2.5-VL-7B-Instruct | ✅ |

| InternVL3-2B | 🚧 |

| Qwen3-VL-4b | 🚧 |

| Qwen3-VL-2b | 🚧 |

安装

bash

sudo aid-pkg update

sudo aid-pkg -i aidgen-sdk模型文件获取

通过命令直接获取并下载模型

bash

sudo aid-pkg -i aidgense

# 查看已支持的模型

aidllm remote-list api

# 下载模型

aidllm pull api [Url]

# 查看已下载模型

aidllm list api

# 删除已下载模型

sudo aidllm rm api [Name]示例应用

模型性能查看方式

💡注意

请确保示例应用能够完整执行成功

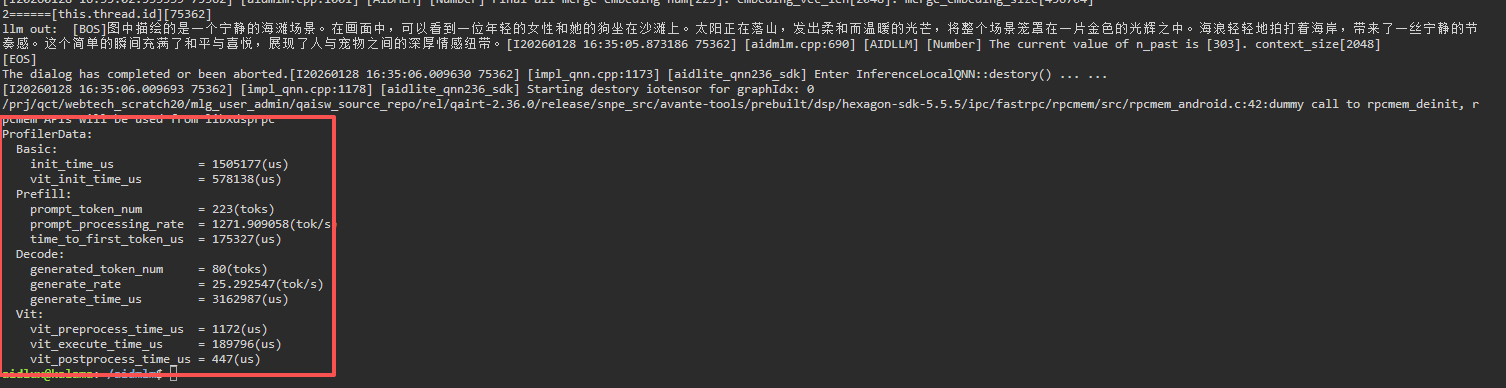

以示例在高通 QCS8550 上部署 Qwen2.5-VL-3B-Instruct (392x392) 为例子

bash

sudo apt update

sudo apt-get install libfmt-dev nlohmann-json3-dev

mkdir build && cd build

cmake .. && make

# 编译成功后运行

# 第一个参数 1 表示开启 profiler 统计

mv test_qwen25vl /home/aidlux/aidmlm/

cd /home/aidlux/aidmlm/

./test_qwen25vl "qwen25vl3b392" "config3b_392.json" "demo.jpg" "请描述一下图中场景" 1- 在终端输入对话内容后会看到如下日志信息: